| New Products |

|

|

赤外線深度センサDTK

赤外線深度センサを使ったNUI開発キット |

|

●別途見積 |

●リリース 2012年1月

シミュレーション |

|

|

|

近年、新しいユーザインタフェースとして、NUI(Natural User Interface)の開発が盛んに行われています。NUIとは、声や体を使うことで直観的な操作を行う新しいインタフェースです。

DTK(Depth Tool Kit)は、赤外線深度センサを使ったNUIの開発キットになります。赤外線深度センサの距離情報からユーザを認識し、体の動きを3次元で取得します。通常のモーションキャプチャのように、体にセンサやマーカを付けなくてもよいことが利点の1つです。

|

DTKで使用可能なデバイスは、Xtion PRO, Xtion PRO LIVE, Kinect™の3つです(図1)。

いずれも赤外線深度センサにはPrimeSense™社の技術を使用しています。片側のレンズから赤外線のレーザを照射し、反対側のレンズで反射光を読み取ります(図2)。図1のセンサでは、緑色のレンズがレーザ、反対側が受光部になっています。

Xtion PRO、Kinect™の中央のレンズはRGBカメラです。Xtion PROは赤外線深度センサのみ搭載しています。

Xtion PRO LIVE及びKinect™はその他の機能を併せ持つ多機能デバイスです(表1)。

| XtionPRO |

Xtion PRO LIVE |

Kinect™センサ |

|

|

|

| ■図1 赤外線深度センサ(Xtion PRO, Xtion PRO LIVE, Kinect™) |

|

|

| ■図2 赤外線レーザーパターン |

| 機能 |

Xtion PRO |

Xtion PRO LIVE |

Kinect™ |

| 赤外線深度センサ |

640×480(VGA)/30fps

320×240(QVGA)/60fps |

| RGBカメラ |

× |

1280×1024

(SXGA) |

640×480(VGA)/30fps

320×240(QVGA)/60fps |

| Audioマイク |

× |

2 |

4 |

| チルトモーター |

× |

× |

○ |

| 接続方式 |

USB2.0 |

USB2.0 |

USB2.0 |

| 電源供給 |

USBバスパワー |

USBバスパワー |

ACアダプター |

■表1 赤外線深度センサ機能比較

DTKでは赤外線深度センサとRGBカメラの機能をサポートします。赤外線深度センサの有効範囲は、Xtion

PRO, Xtion PRO LIVEで公称値0.8m〜3.5mです。Kinect™は公称値で1.2m〜3.5mとなっています。

|

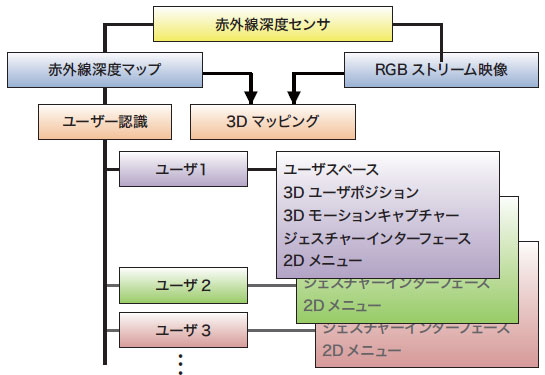

DTKは赤外線深度センサーの利用を簡単にするツールキットです。深度マップ、RGBカメラ映像の取得はもちろん、ユーザの認識から3次元のモーション取得まで、命令を送るだけで簡単に行えます(図3)。複数のユーザを同時に認識・操作することも可能で、ジェスチャインタフェースや2Dメニュー作成機能を使えば、すぐに入力デバイスとして使用できます。

■図3 DTK(Depth ToolKit)の機能)

深度マップの情報や3次元のモーションデータを使い、まったく異なるアプリケーションを作成することも可能です。

|

DTKは言語やプラットフォームによらず使用できます(図4)。Visual Studio®など、C++ではクラスライブラリとして使用します。クラスとして宣言した後、必要なメンバ関数を呼び処理を行います。深度マップ、RGBカメラのデータの他、ジェスチャー入力などの処理ではイベントを返します。イベントに合った処理を記述することで、簡単に赤外線深度センサを使ったアプリケーションを作成できます。その他の言語・プラットフォームでは、UDP通信を使用したサーバーとして機能します。ユーザ側はクライアントプログラムとして、DTKと通信しながら赤外線深度センサの情報を利用します。別アプリケーションとして機能するため、言語やプラットフォームによらずDTKを使用できます。

■図4 DTK使用方法

クライアント側は、UDPでサーバと接続した後、実行したい処理や必要な情報をDTKに送信します。DTKは要求に応じ、クライアントプログラムへデータを受け渡します。バックグラウンドプログラムとして使用するほか、深度マップやRGB画像の表示をDTK側で行わせることもできます。

|

| AirDriving &Gesture Interface |

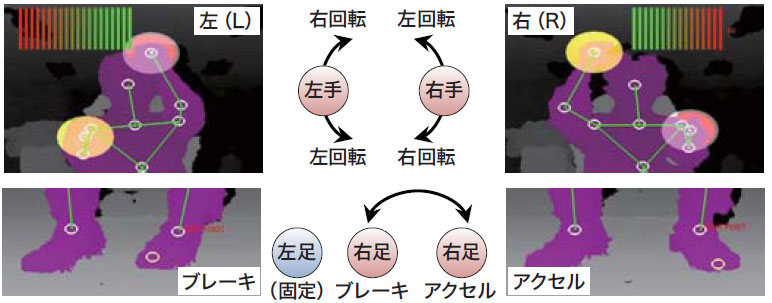

AirDriving & Gesture Interfaceは、3次元モーション入力とジェスチャー入力を組み合わせたハンドレスドライビングシステムです(図5)。赤外線深度センサから入力された手足の情報を使い、UC-win/Roadのモデルを走行します(図6)。ステアリング操作は、ハンドルを持つように両手を動かします。アクセル/ブレーキ操作はペダルを踏むように右足を動かし、つま先の左右でアクセル/ブレーキ、上下で踏込みの強さを表します。わずかな動きも認識するため、スムーズな運転が可能です。

|

|

|

| ■図5 AirDriving(東京ゲームショウ2011) |

|

■図6 AirDriving運転操作 |

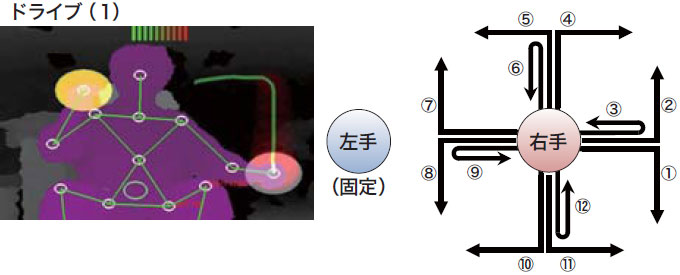

ドライブ/バックの切替えはジェスチャで行います。ジェスチャの入力は、左手を固定した状態で、図7のように右手を動かします。AirDrivingではジェスチャの1番をドライブ、2番をバックとして使用します。シナリオなどにその他のジェスチャを割り当てることで、マウス・キーボードを使うことなく運転開始から終了まで操作できます。

■図7 AirDriving ドライブ(1)/バック(2)

|

フォーラムエイトではAirDrivingを始め、ロボットのテレオペレーションなど赤外線深度センサを利用したアプリケーションを開発しています(表2、3)。

| アプリケーション |

赤外線深度センサの用途 |

| A)シミュレータ |

| AirDriving |

ハンドレスドライビング |

| B)テレオペレーション |

| RoboCar® |

ドライビングコントロール |

| AGUL AR.Drone |

フライングコントロール |

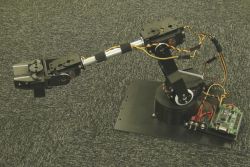

| ロボットアーム |

モーションコントロール |

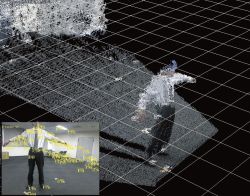

| SLAM |

3Dマッピング |

■表2 赤外線深度センサを使用したアプリケーション

| 機能 |

AirDriving |

RoboCar® |

AGUL AR.Drone |

ロボットアーム |

SLAM |

| 深度マップ |

○ |

○ |

○ |

○ |

○ |

| RGBストリーム映像 |

× |

× |

× |

× |

○ |

| ユーザースペース |

○ |

○ |

○ |

○ |

× |

| 3Dモーションキャプチャー |

○ |

○ |

○ |

○ |

× |

| Gesture Interface |

× |

○ |

○ |

○ |

× |

■表3 各アプリケーションの赤外線深度センサ利用形態

RoboCar®はZMP社の1/10スケールモデルカーです。AirDrivingとジェスチャインタフェースを使い、UC-win/RoadとRoboCar®を同期した走行シミュレーションを行います。AGUL AR.Drone(P9,Up&Coming 95号)はParrot社のクアッドコプターです(図8)。安定した飛行が可能で、空中からの写真撮影などに活用できます。AGUL AR.Droneやロボットアーム(図9)も3DモーションキャプチャとGestureInterfaceを使い制御できます。SLAM(Simultaneous Localization And Mapping)は自己位置推定と環境地図作成を同時に行うシステムです(図10)。赤外線深度センサの距離情報とRGBカメラのカラー情報の合成によりリアルタイムに3次元点群モデル(環境地図)を作成し、取得した映像を逐次比較して1つの連続した空間を生成します(自己位置推定)。これはロボットの制御や3Dマッピングに使用します。

|

|

|

| ■図8 AGUL AR.Drone(Parrot社) |

■図9 アームロボット AL5D(Lynxmotion社) |

■図10 SLAMを使用した

3Dスキャニング |

DTKはこのようなアプリケーションの開発をサポートしています。 |

|

>> 製品総合カタログ

>> プレミアム会員サービス

>> ファイナンシャルサポート

|